Quantum Money (tiền lượng tử) là một khái niệm tiền tệ dựa trên các nguyên lý của cơ học lượng tử, trong đó tính xác thực của tiền được bảo vệ bởi các quy luật vật lý, chứ không chỉ bằng thuật toán mật mã như tiền điện tử hiện nay.

Khái niệm quantum money được đề xuất lần đầu bởi Stephen Wiesner vào đầu thập niên 1970. Ý tưởng dựa trên định lý không sao chép (no-cloning theorem) của cơ học lượng tử, theo đó không thể sao chép hoàn hảo một trạng thái lượng tử chưa biết.

Quantum money hoạt động thế nào?

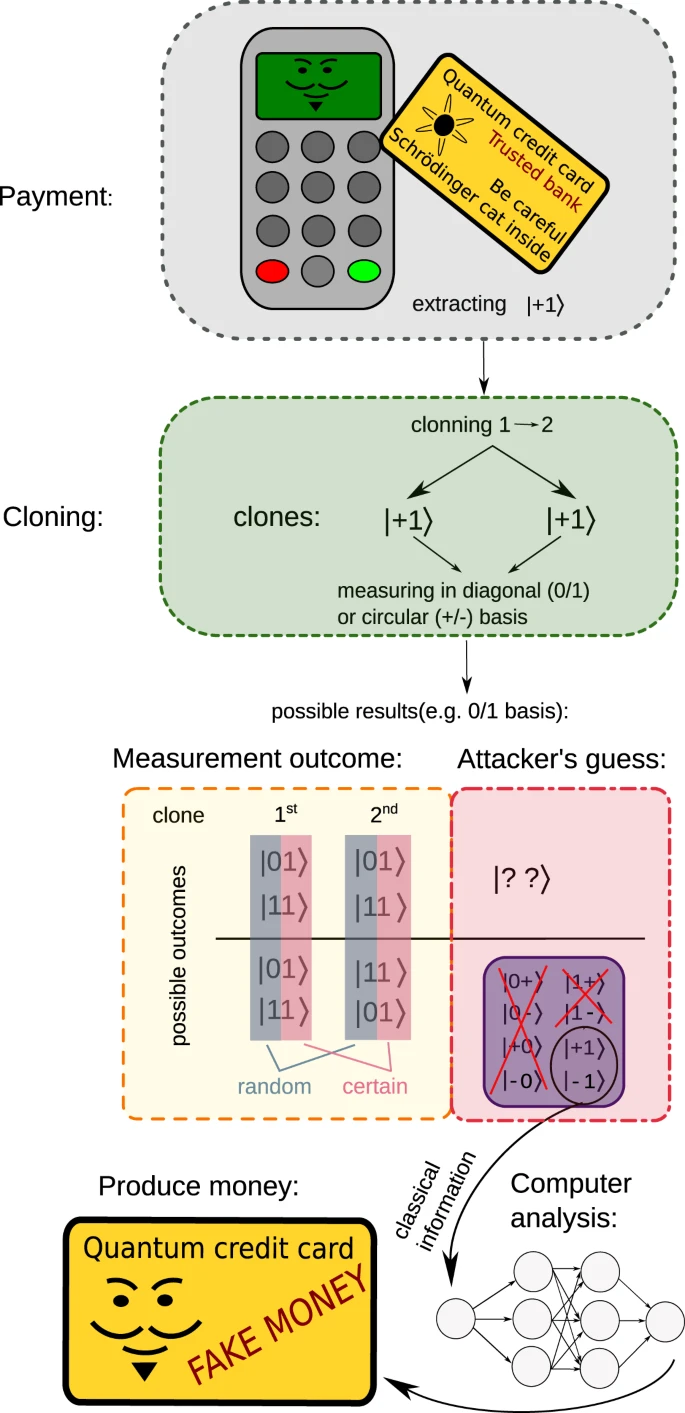

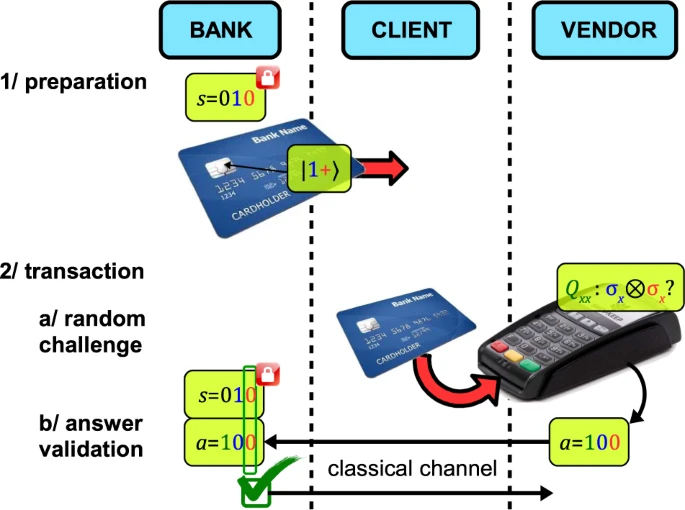

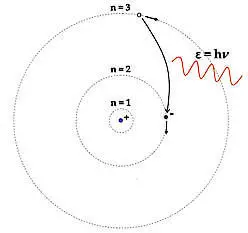

- Mỗi “tờ tiền” chứa một trạng thái lượng tử bí mật (ví dụ: các qubit ở những trạng thái khác nhau).

- Ngân hàng trung ương biết cách kiểm tra trạng thái đó.

- Người làm giả sẽ không biết trạng thái chính xác, không thể sao chép qubit, nếu đo sai cách thì trạng thái bị phá hủy. Vì vậy, tiền giả sẽ tự lộ diện khi kiểm tra.

Quantum Money và Cryptocurrency

- Cryptocurrency được xây dựng trên mật mã học và công nghệ blockchain. Tính an toàn của nó đến từ các thuật toán toán học phức tạp, chữ ký số và cơ chế đồng thuận của mạng lưới phi tập trung. Một đồng tiền mã hóa không thể bị “chi tiêu hai lần” vì mọi giao dịch đều được ghi lại và kiểm chứng công khai. Tuy nhiên, về bản chất, cryptocurrency vẫn dựa vào giả định rằng việc phá vỡ thuật toán là không khả thi về mặt tính toán. Khi máy tính lượng tử đủ mạnh xuất hiện, một số thuật toán mật mã hiện nay có thể đối mặt với rủi ro.

- Ngược lại, quantum money là một ý tưởng mang tính cách mạng hơn về mặt nguyên lý. Nó không dựa vào độ khó tính toán, mà dựa trực tiếp vào các định luật của cơ học lượng tử, đặc biệt là nguyên lý không thể sao chép trạng thái lượng tử. Mỗi “đơn vị tiền” chứa một trạng thái lượng tử bí mật. Người làm giả không thể sao chép trạng thái này, và nếu đo sai cách để tìm hiểu, trạng thái sẽ bị phá hủy. Nói cách khác, quantum money được bảo vệ bởi luật tự nhiên, chứ không phải bởi thuật toán.

Tài liệu tham khảo và đọc thêm

- https://www.worldfinance.com/the-econoclast/quantum-money

- https://www.weizmann.ac.il/math/vidick/sites/math.vidick/files/uploads/chapter3.pdf

- https://simons.berkeley.edu/sites/default/files/docs/15588/qmoney-berkeley.pdf

- https://pdf.pirsa.org/files/10010078.pdf

.jpg)