1. Data processing là gì?

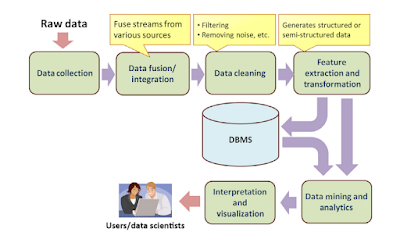

Data processing là quá trình xử lý dữ liệu từ các nguồn khác nhau để tạo ra thông tin hữu ích và có ý nghĩa. Quá trình này bao gồm nhiều công đoạn từ việc thu thập dữ liệu, làm sạch, sắp xếp, xử lý, và trình bày thông tin để tạo ra kết quả có thể sử dụng được.

2. Phân biệt data processing với data management

Data processing và Data management là hai khái niệm liên quan đến việc làm việc với dữ liệu, nhưng chúng có các mục tiêu và phạm vi hoạt động khác nhau.

Data Processing:

- Data processing là quá trình xử lý dữ liệu từ nguồn gốc đến khi nó trở thành thông tin có ý nghĩa. Quá trình này bao gồm thu thập, làm sạch, xử lý và trình bày dữ liệu để tạo ra thông tin hữu ích.

- Mục tiêu chính của data processing là chuyển đổi dữ liệu từ dạng nguyên thô, không có cấu trúc và không có ý nghĩa thành dữ liệu có cấu trúc, được xử lý và dễ hiểu.

- Data processing tập trung vào việc biến dữ liệu thành thông tin có giá trị để hỗ trợ quyết định và hoạt động kinh doanh.

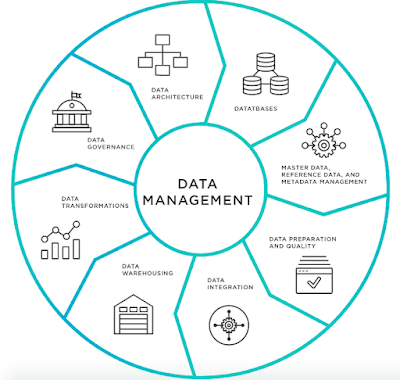

Data Management:

- Data management là quá trình tổ chức và quản lý các nguồn lực liên quan đến dữ liệu. Nó bao gồm việc lưu trữ, bảo quản, cập nhật, và bảo mật dữ liệu.

- Mục tiêu chính của data management là quản lý và duy trì dữ liệu trong toàn bộ vòng đời của nó, từ khi được tạo ra, sử dụng, lưu trữ, đến khi bị xóa hoặc vô hiệu.

- Data management tập trung vào việc đảm bảo tính toàn vẹn, an ninh và sẵn sàng của dữ liệu, đồng thời tuân thủ các quy định pháp luật và chuẩn mực liên quan đến dữ liệu.

Tóm lại, data processing liên quan đến việc xử lý dữ liệu để tạo ra thông tin có ý nghĩa, trong khi data management tập trung vào việc quản lý và duy trì dữ liệu để đảm bảo tính toàn vẹn và sẵn sàng của nó trong suốt quá trình sử dụng.

3. Phân biệt data processing với data analysis

Data Processing:

- Về mục tiêu: Data processing nhằm chuyển đổi dữ liệu từ dạng nguyên thô thành dạng có cấu trúc, dễ hiểu và có ý nghĩa hơn.

- Về phạm vi: Data processing tập trung vào các bước như thu thập dữ liệu, làm sạch dữ liệu (data cleaning), xử lý dữ liệu (data processing) và chuẩn bị dữ liệu để sử dụng trong quá trình phân tích.

- Về mục đích: Mục đích của data processing là làm cho dữ liệu trở nên dễ hiểu hơn, loại bỏ nhiễu, và chuẩn bị nó để có thể áp dụng các phương pháp phân tích dữ liệu.

Data Analysis:

- Về mục tiêu: Data analysis nhằm tìm ra thông tin và hiểu biết từ dữ liệu đã được xử lý để có thể đưa ra quyết định hoặc dự đoán.

- Về phạm vi: Data analysis liên quan đến việc áp dụng các kỹ thuật phân tích dữ liệu như thống kê, machine learning, data mining để tìm ra xu hướng, mô hình, hay nhận biết các mối quan hệ trong dữ liệu.

- Về mục đích:: Mục đích của data analysis là tìm ra thông tin có giá trị từ dữ liệu đã qua quá trình xử lý, từ đó hỗ trợ ra quyết định, dự đoán, và tối ưu hóa quy trình.

Tóm lại, data processing tập trung vào việc xử lý dữ liệu từ nguyên thô đến dạng có cấu trúc và dễ phân tích hơn, trong khi data analysis là quá trình sử dụng các kỹ thuật phân tích để tìm ra thông tin có giá trị từ dữ liệu đã được xử lý. Hai khái niệm này thường được sử dụng liên quan đến nhau trong quá trình làm việc với dữ liệu.

4. Các yêu cầu quan trọng khi thực hiện Data processing:

Tính toàn vẹn của dữ liệu (Data Integrity):

- Dữ liệu phải được bảo vệ khỏi mất mát, sự thay đổi không cần thiết hoặc các vấn đề về độ chính xác khi được xử lý. Tính toàn vẹn của dữ liệu là yếu tố quan trọng trong mọi quá trình xử lý dữ liệu.

Bảo mật thông tin (Data Security):

- Dữ liệu nhạy cảm cần phải được bảo vệ khỏi truy cập trái phép và lỗ hổng bảo mật. Việc áp dụng các biện pháp an ninh để bảo vệ dữ liệu là rất quan trọng trong quá trình xử lý dữ liệu.

Tính khả dụng (Data Availability):

- Dữ liệu cần phải có sẵn và có thể truy cập khi cần thiết. Điều này bao gồm việc lưu trữ dữ liệu một cách an toàn và cung cấp khả năng truy cập hiệu quả và nhanh chóng cho người dùng cần dữ liệu.

Đúng định dạng và cấu trúc (Data Format and Structure):

- Dữ liệu cần phải được chuẩn hóa và định dạng một cách đồng nhất để đảm bảo tính nhất quán và dễ dàng trong việc xử lý và phân tích.

Hiệu suất (Performance):

- Quá trình xử lý dữ liệu cần phải được thực hiện một cách hiệu quả với tốc độ xử lý nhanh và ít tốn tài nguyên, đặc biệt là khi xử lý dữ liệu lớn (Big Data).

Sự linh hoạt (Flexibility):

- Phải có khả năng thích nghi với sự thay đổi, mở rộng và cải thiện quy trình xử lý dữ liệu theo thời gian, để có thể đáp ứng nhu cầu và yêu cầu mới.

Tương thích và tích hợp (Compatibility and Integration):

- Dữ liệu xử lý cần phải tương thích và có khả năng tích hợp với các hệ thống và công cụ khác trong tổ chức để đảm bảo tính liên tục và hiệu quả của quá trình.

Tuân thủ quy định và chuẩn mực (Compliance and Standards):

- Cần tuân thủ các quy định và chuẩn mực về bảo mật, quản lý dữ liệu, và quy định pháp luật liên quan đến việc xử lý dữ liệu.

Tuân thủ các yêu cầu này là cực kỳ quan trọng để đảm bảo rằng quá trình Data processing diễn ra một cách an toàn, chính xác và hiệu quả.

5. Các công cụ hỗ trợ data processing

Có nhiều công cụ và phần mềm mạnh mẽ được sử dụng để hỗ trợ quá trình Data processing, giúp xử lý dữ liệu từ các nguồn khác nhau và chuyển đổi chúng thành thông tin có ý nghĩa. Một số công cụ phổ biến được sử dụng trong Data processing như:

Apache Hadoop:

Hadoop là một framework mã nguồn mở cho việc xử lý dữ liệu lớn (Big Data) dựa trên mô hình phân tán. Nó cung cấp các công cụ để lưu trữ và xử lý dữ liệu lớn trên các cụm máy tính.

Apache Spark:

Spark là một framework xử lý dữ liệu phân tán và có hiệu suất cao, thường được sử dụng cho xử lý dữ liệu thời gian thực và tính toán song song.

Python và R:

Python và R là hai ngôn ngữ lập trình phổ biến được sử dụng trong việc xử lý dữ liệu, làm sạch dữ liệu, thực hiện phân tích và trực quan hóa dữ liệu.

SQL Databases (MySQL, PostgreSQL, Oracle):

Các cơ sở dữ liệu quan hệ được sử dụng rộng rãi để lưu trữ và xử lý dữ liệu. Các ngôn ngữ truy vấn như SQL được sử dụng để truy xuất và biến đổi dữ liệu trong các cơ sở dữ liệu này.

ETL (Extract, Transform, Load) Tools:

Các công cụ ETL như Talend, Informatica, và SSIS (SQL Server Integration Services) được sử dụng để trích xuất dữ liệu từ nhiều nguồn, biến đổi và làm sạch dữ liệu, sau đó tải nó vào cơ sở dữ liệu hoặc hệ thống khác.

Microsoft Excel và Google Sheets:

Các công cụ bảng tính như Excel và Google Sheets cung cấp các chức năng cơ bản để làm sạch và xử lý dữ liệu, cũng như tạo các báo cáo và biểu đồ đơn giản.

Tableau, Power BI, QlikView:

Các công cụ này cung cấp khả năng trực quan hóa dữ liệu và tạo các bảng điều khiển, biểu đồ, và báo cáo từ dữ liệu đã được xử lý để hiển thị thông tin một cách trực quan và dễ hiểu.

Những công cụ này cung cấp các tính năng và chức năng đa dạng để hỗ trợ quá trình Data processing tùy thuộc vào yêu cầu cụ thể của dự án hoặc tổ chức.

Tài liệu tham khảo

- https://www.britannica.com/technology/data-processing

- https://www.talend.com/resources/what-is-data-processing/

- https://www.simplilearn.com/what-is-data-processing-article

- https://www.indeed.com/career-advice/career-development/what-is-data-processing

- https://www.astera.com/knowledge-center/what-is-data-processing-definition-and-stages/